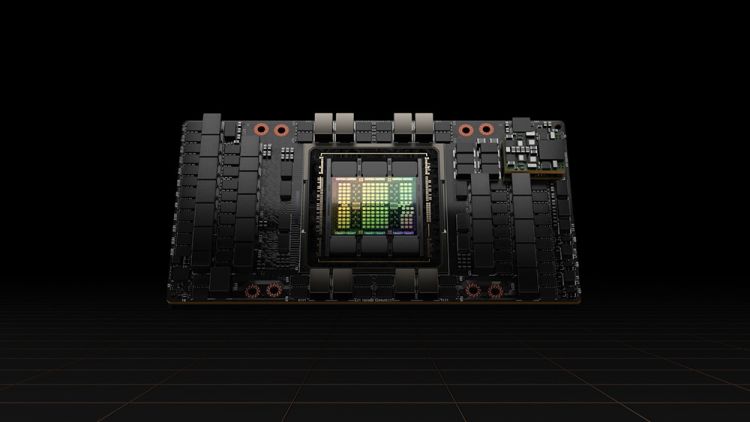

Meta-Chef Mark Zuckerberg gab anlässlich eines kürzlichen Investoren-Calls an, dass sein Unternehmen die neuen Llama-4-Sprachmodell auf einem Cluster trainiere, der über 100'000 KI-GPUs vom Typ Nvidia H100 umfasse. "Das ist grösser als alles, von dem berichtet wird, was andere tun." Dies schreibt unter anderem "Tom's Hardware" in einem Artikel. Gigantisch ist auch der Stromverbrauch eines 100'000-H100-Clusters: Er beläuft sich pro Jahr auf mindestens 370 Gigawattstunden.

Weitere Details zu Llama 4 gab Zuckerberg den Investoren laut dem Bericht nicht bekannt. Laut "Wired" hat sich Zuckerberg in punkto Llama 4 geäussert, es warte mit "neuen Modalitäten und stärkerer Argumentation" auf und sei "viel schneller". Ob der KI-GPU-Cluster von

Meta nun wirklich der grösste ist, ist unklar. Denn X-Eigner Elon Musk hatte im Juli 2024 einen vergleichbaren Cluster angekündigt, ihn "Gigafactory of Compute" genannt und von Plänen gesprochen, den Cluster auf 200'000 KI-GPUs auszubauen. Aber: Bereits Anfang 2024 hat Meta Erwartungen verkündet, bis Ende Jahr über eine halbe Million mit H100 vergleichbare KI-GPUs einzusetzen. Das Rennen bleibt somit offen.

Llama 4 wird im Gegensatz zu OpenAIs GPT-40 oder Googles Gemini für Forscher, Unternehmen und Organisationen offen und kostenlos veröffentlicht, wenn auch unter gewissen Bedingungen. So ist etwa die kommerzielle Nutzung von Llama 4 eingeschränkt. GPT-40 und Gemini sind dagegen nur via API zugänglich.

(ubi)