BI muss raus aus der Expertenecke

Artikel erschienen in Swiss IT Magazine 2010/03

Von 2006 bis 2009 rangierte Business Intelligence (BI) gemäss dem Marktforschungsunternehmen Gartner bei CIOs stets unter den zehn Technologien mit höchster Priorität. In einer aktuellen Studie von Steria Mummert Consulting gaben zwei Drittel der befragten Manager aus deutschsprachigen Unternehmen an, bereits BI-Technologie zu nutzen. Mehr als 80 Prozent planen zudem die Einführung solcher Werkzeuge. Doch noch immer sind BI-Lösungen bei vielen Unternehmen lediglich punktuell im Einsatz, beispielsweise um bestehende Prozesse abzubilden oder das Reporting zu verbessern. Strategische Ansätze sind oft kaum vorhanden.

Gerade für kleinere Unternehmen sind traditionelle BI-Lösungen, die Datenbestände für detaillierte Auswertungen separat aggregieren und dann nach dem OLAP-Verfahren (Online Analytical Prozessing) durchforsten, zu komplex, zu aufwendig und zu teuer. Hinzu kommt, dass diese traditionellen Lösungen in bezug auf Datenvolumen und Auswertungsdimensionen schnell an ihre Leistungsgrenze stossen. Als Folge davon verweigern sich viele Anwender der Nutzung von BI-Software. Die Lösungen sind schlicht zu komplex, wenn sie denn funktionieren. Eine aktuelle Untersuchung von Actinum Consulting zeigt, dass rund 58 Prozent der BI-Anwenderunternehmen mit der Auswahl ihres Tools unzufrieden sind. Ein Grossteil der installierten Lösungen läuft also nicht so, wie sich das die Auftraggeber zum Zeitpunkt des Projektstarts offensichtlich vorgestellt hatten.

Die Richtung, welche die Hersteller einschlagen müssen, steht deshalb fest. Sie müssen sich weg von komplexen Lösungen und hin zu einfach bedienbaren Werkzeugen bewegen, die eine effiziente und gleichzeitig flexible Analyse von Geschäftsdaten per Mausklick ermöglichen. Die Unternehmen möchten ihre Geschäftsentscheidungen nicht länger auf Basis statischer Berichte oder improvisierter Excel-Tabellen treffen, die nur von wenigen Experten mit grossem Aufwand erstellt werden können. Sie benötigen skalierbare BI-Werkzeuge, die sich binnen weniger Tage in die Geschäftsprozesse implementieren lassen. Ausserdem brauchen sie eine Software, die so einfach zu bedienen ist, dass langwierige Anwender-Schulungen überflüssig werden. KMU brauchen Lösungen, die das Thema BI aus der Expertenecke herausholen, wo es noch bis vor kurzem angesichts der Komplexität der am Markt etablierten Systeme angesiedelt war.

Einen zukunftsweisenden Ansatz zur Lösung dieser Probleme stellt die In-Memory-Analyse dar. Moderne BI-Werkzeuge verzichten auf eine aufwendige und starre Definition des Datenmodells und laden alle erforderlichen Daten von Anfang an direkt in den Arbeitsspeicher. Anschliessend finden hier alle Berechnungen und logischen Verknüpfungen statt. Das ermöglicht einerseits Abfragen und Analysen mit kürzesten Antwortzeiten, wobei sich selbst umfangreiche Massendaten nahezu in Echtzeit analysieren lassen. Andererseits bietet die permanente Verfügbarkeit aller Daten beziehungsweise Dimensionen im Arbeitsspeicher eine bislang unbekannte Flexibilität in Hinsicht auf den Analyse-Blickwinkel. Aus dem Tagesgeschäft heraus können die Fragestellungen somit jederzeit durch Hinzufügen neuer Dimensionen oder Kennzahlen beliebig variiert werden. Erst so wird eine echte Interaktion mit aktuellen Daten aus den operativen Prozessen möglich. Und das wiederum ist eine elementare Voraussetzung dafür, dass Unternehmen ihre Prozesse proaktiv steuern und optimieren können.

Diese Fortschritte in Sachen Schnelligkeit und Flexibilität basieren auf verschiedenen technischen Innovationen. Zum einen sind viele Hersteller konventioneller BI-Lösungen bei der Entwicklung ihrer Systeme von begrenzten Prozessor-Geschwindigkeiten und hohen Kos-ten für Speicherplatz ausgegangen. Tatsächlich aber sind die Preise von Speicherbausteinen in den vergangenen Jahren stark gesunken. Gleichzeitig haben sich die Prozessorleistungen vervielfacht. Neue BI-Lösungen machen sich diese Vorteile zunutze und schöpfen mit 64-Bit-Plattformen die Kapazitäten der Arbeitsspeicher voll aus. Entsprechend fällt die bisherige Beschränkung auf maximal vier Gigabyte Adressraum im Arbeitsspeicher weg. Das ermöglicht Analysen, Berechnungen und logische Verknüpfungen jeder Grössenordnung im Moment der Datenabfrage – bis hin zu mehreren Milliarden Datensätzen bis auf Transaktionsebene in ein und derselben Anwendung.

Zudem erlauben neueste Verfahren, selbst grösste Datenvolumina in kürzester Zeit zu laden. Nach dem Laden kommen intelligente Rechenalgorithmen respektive statistische Funktionen zum Zuge, mit denen die Metadaten extrahiert und in separaten Dateien gespeichert werden. Dabei werden alle Redundanzen ausgemerzt. Die originalen Daten legt das BI-System anschliessend in einer assoziativen Datenbank im Arbeitsspeicher in stark komprimierter Form ab.

Diese BI-Werkzeuge integrieren, verknüpfen und analysieren Daten aus nahezu allen üblichen Formaten. Unter anderem gilt das für Daten aus ERP-Systemen wie etwa SAP oder Navision, Datenbanken wie Oracle, AS/400 oder Access und anderen Quellen wie Excel-Tabellen oder dem Internet. Zusätzliche ETL-Werkzeuge (Extract, Transform, Load) oder Data Warehouses sind nicht erforderlich, lassen sich aber flexibel in die Analysen einbeziehen, falls sie bereits vorhanden sind.

Ein weiterer Vorteil moderner BI-Werkzeuge ist, dass die Daten, egal woher sie geladen werden, vorher nicht zeitraubend aufbereitet werden. Konventionelle Systeme arbeiteten dagegen häufig mit aggregierten Datenbeständen und Cubes, die eine aufwendige Modellierung und Definition aller Dimensionen und Hierarchien voraussetzen. Aufgaben, bei denen sowohl das Management als auch die Fachabteilungen in aller Regel auf die Hilfe der IT-Experten angewiesen waren. Analysten mussten gemeinsam mit ihren IT-Fachleuten vorab bestimmen und antizipieren, welche Anfragen sie später an ihre Systeme stellen wollten.

Änderten sich später die Fragestellungen, mussten diese meist in den IT-Abteilungen neu programmiert werden. Somit erforderte das Implementieren konventioneller BI-Werkzeuge einerseits beim Aufbereiten der Daten enormen Aufwand. Andererseits waren traditionelle Lösungen im Hinblick auf die Analyse-Blickwinkel und Fragestellungen wenig flexibel.

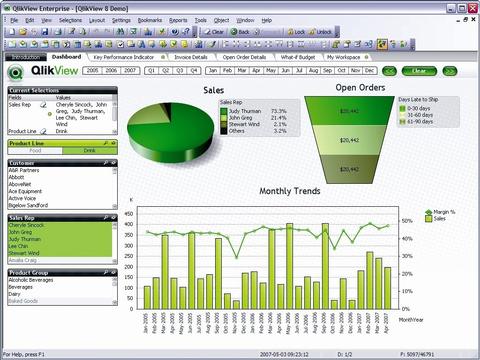

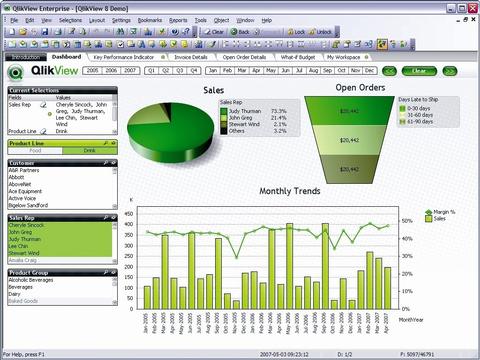

Angefangen bei einfachen Dashboards mit nur den wichtigsten Geschäftskennzahlen bis hin zu komplexen Analysen – heutige BI-Werkzeuge decken eine breite Palette unterschiedlicher und individueller Anforderungen ab. Gleichzeitig können die für die Geschäftsprozesse verantwortlichen Mitarbeiter dank integrierter, individuell konfigurierbarer Alarmfunktionen praktisch in Echtzeit auf kritische Veränderungen in den Daten reagieren. Überschreiten in der Datenbasis Veränderungen die einmal bestimmten Grenzwerte, schlägt die Software automatisch Alarm, startet andere Anwendungen oder verschickt E-Mails an die verantwortlichen Personen.

Die Vorteile innovativer BI-Werkzeuge wie die schnelle Implementierung in Geschäftsprozesse, die einfache Administration und die leichte Bedienbarkeit schlagen in der Kostenkalkulation entsprechender Projekte sichtlich zu Buche. Viele Unternehmen erreichen hier heute Amortisationszeiten von unter einem Jahr. Hinzukommen die langfristigen Vorteile durch eine Reaktion auf identifizierte Entwicklungspotentiale, wie beispielsweise eine bessere Maschinenauslastung oder erhöhte Lieferverfügbarkeit. Und schliesslich profitieren Unternehmen von den zusätzlichen Entwicklungspotentialen innerhalb ihrer IT-Abteilungen, die sich dank freier Ressourcen neuen Herausforderungen widmen können.