Ollama

Der Download wird vorbereitet....

Voraussichtliche Download-Zeiten:

5 Mbps: 27 Minuten, 23 Sekunden

20 Mbps: 6 Minuten, 50 Sekunden

Voraussichtliche Download-Zeiten:

5 Mbps: 27 Minuten, 23 Sekunden

20 Mbps: 6 Minuten, 50 Sekunden

| Version: | 0.65 | ||

| Hersteller/Autor: | Community | ||

| Betriebssysteme: | Win 8 (32bit), Win 10/11 (32bit) | ||

| Sprache: | Deutsch | ||

| Dateigrösse: | 1’027’363 KB | ||

| Letztes Update: | 12. April 2025 |

DOWNLOAD |

|

| Anzahl Downloads: | 8 | ||

| Wertung: | |||

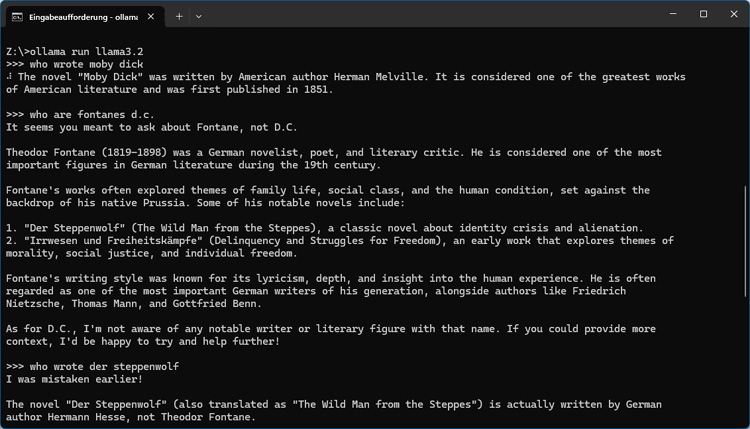

Bei Ollama handelt es sich um eine lokal betriebene Plattform, um grosse KI-Sprachmodelle (LLMs) zu konfigurieren und lokal bzw. offline einzusetzen. Ollama kommt unter anderen mit den LLMs Llama, Gemma, DeepSeek oder Mistral zurecht, ohne dass dafür eine Registrierung nötig wäre. Die Bedienung erolgt über den Windows-eigenen Command Prompt. So lässt sich nach der Installation mit der Anweisung "ollama run llama3.2" gleich ein Chat mit dem Llama-3.2.-Modell starten. Ollama ist weiter in der Lage LLMs anzupassen und unterstützt die GPU-Features von Nvidia und AMD. Ebenfalls vorhanden ist ein API für die Anbindung an weitere Projekte.